Bei einem Bastelprojekt (OpenDTU) mit einem ESP32 (genauer: DUBEUYEW SP-Cow ESP32 NodeMCU-32S ESP-WROOM-32 mit 38 Pins und USB-C) ist mir ein Fehler passiert. Diesen Fehler zu finden hat lange gedauert und nur irgendein Kommentar in einem Forum hat mich auf die Lösung gebracht. Falls noch jemand den gleichen Fehler macht, geht es hiermit vielleicht schneller zu einer Lösung.

Das war die Aufgabe: Ein ESP32 sollte zusammen mit einem SMD-Funkmodul in ein wasserdichtes Gehäuse eingebaut werden. Zur Stromversorgung sollte ein USB-Kabel dienen. Um Platz im Gehäuse zu sparen hab ich den Stecker abgeschnitten, um die 5V direkt an den 5V- und GND-Pin anzuschließen. Beim Testbetrieb (noch ohne Gehäuse) mit Stromversorgung über USB-C hat alles einwandfrei funktioniert. Gleich nach dem Einstecken leuchtet eine rote LED und kurz danach sieht man das OpenDTU WLAN und der ESP meldet sich im Heim-WLAN an (wenn man das schon konfiguriert hat).

Das Problem: Nach dem Einbau ins Gehäuse und dem Umstellen auf die 5V-Spannungsversorgung ging nichts mehr. Die rote LED war an, aber sonst nichts, kein OpenDTU WLAN und keine Anmeldung im Heim-WLAN. Und der ESP32 (also der große Chip in der Mitte) wurde relativ schnell heiß. Und das obwohl der 5V-Pin für Spannungen von 5 bis 12V gemacht ist.

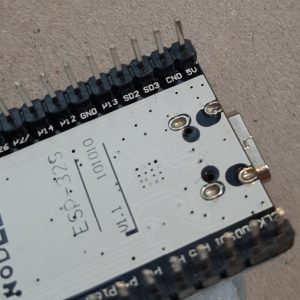

Der Fehler: Ich hab beim Verkabeln nur auf die Beschriftung am ESP-Board geschaut, nicht auf die Pin-Out-Dokumentation (alles was ich als „Doku“ finden konnte war ein Bild bei Amazon). Und leider ist die Beschriftung am Board falsch. Der PIN direkt neben dem 5V ist nämlich nicht wie vermutet ein GND-Pin, sondern CMD. Am Board steht CND, was auch immer das sein soll. Leider dachte ich, das wäre der GND, auch weil es andere 38-Pin ESPs gibt, bei denen tatsächlich GND direkt neben dem 5V-Pin ist.

Kaum war GND an den richtigen Pin angeschlossen, schon hat alles funktioniert. Und das Board hat es auch überlebt.